Le guide pour comprendre le crawling et l’indexation sur Google

L’indexation et le crawling sont des pratiques centrales de Google qui consistent pour le moteur de recherche à explorer, plus ou moins...

L’indexation et le crawling sont des pratiques centrales de Google qui consistent pour le moteur de recherche à explorer, plus ou moins...

Le réseau social a publié ses résultats financiers pour le deuxième trimestre 2019. Bonne nouvelle : ils sont en hausse, de...

Il n’y a pas que le Tour de France à fêter ses champions. Les championnats du monde du jeu Fortnite avaient en effet lieu ce week-end....

Un simple clic pourrait bientôt suffire pour se connecter au réseau Tor depuis Firefox. The post Firefox pourrait bénéficier...

Vous êtes community / social media manager ou rédacteur web et vous cherchez un emploi en CDI ? Voici 10 opportunités. The post...

Interview d’un influenceur pas comme les autres, Walter Laouadi. The post Interview : comment Walter Laouadi a mis le storytelling au cœur de...

Il existe deux grands types d’achats chez les internautes. D’un côté, les achats impulsifs. De l’autre, les achats...

Lorsque vous mettez en place une stratégie de marketing content, tout doit être pensé par rapport aux objectifs que vous souhaitez...

Combien avez-vous eu d’auditeurs sur les différentes plateformes ? Quel est leur profil ? Écoutent-ils jusqu’au...

La typographie n’est pas le seul élément visible d’un packaging, le design et les graphismes comptent tout autant. Mais les polices...

L’indexation et le crawling sont des pratiques centrales de Google qui consistent pour le moteur de recherche à explorer, plus ou moins régulièrement,...

L’indexation et le crawling sont des pratiques centrales de Google qui consistent pour le moteur de recherche à explorer, plus ou moins régulièrement, les pages et contenus d’un site web.

Ces algorithmes, qui déterminent la position des sites, influencent grandement leur trafic.

Nous faisons le point, pour vous, sur l’ensemble des éléments à connaître pour une meilleure maîtrise de votre référencement SEO en 2019.

La structuration et la position d’un site sur les moteurs de recherche représentent un travail colossal d’organisation.

En effet, Internet compte plus de 4,1 milliards d’utilisateurs dans le monde.

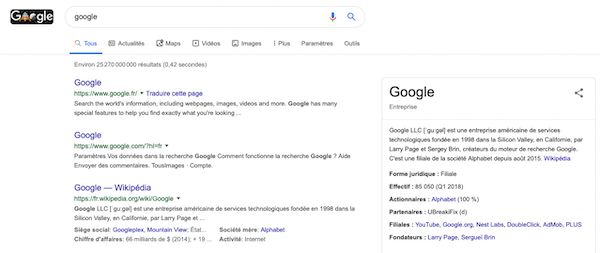

Avec plus de 30 000 milliards de pages indexées par le moteur de recherche Google , une simple recherche peut générer plus de 25 milliards de résultats.

En 2018, pas moins de 1,4 milliard de sites ont vu le jour. La tendance risque donc de s’accentuer dans les années à venir, à plus forte raison que de plus en plus de logiciels permettent aujourd’hui de créer rapidement et simplement un site web.

Les robots d’indexation Google, appelés Crawlers, ont pour objectif d’analyser les différentes pages web afin d’évaluer leur pertinence et leur autorité.

Cette analyse permet de déterminer un pagerank et une position sur les moteurs de recherche.

On nomme ce concept d’analyse le « budget crawl ». Il occupe une place prépondérante dans l’optimisation du SEO.

Pour améliorer la position des pages, les experts SEO cherchent, entre autres, à :

Il convient de noter que le crawling Google concerne près de 20 milliards de sites par jour. Ce travail permet ainsi de proposer des résultats qualitatifs en une fraction de seconde.

L’outil Google Search Console permet de réaliser un rapport de couverture d’index. Ce rapport indique le nombre et le détail des pages que Google a indexées.

Il s’agit d’une première étape permettant de comprendre le positionnement d’un site.

Les algorithmes de recherche sur Google fonctionnent en combinant plusieurs informations essentielles. Ainsi, Google prend en compte :

Il est important de souligner que le moteur de recherche Google analyse également les informations personnelles de l’internaute.

Ainsi, les résultats obtenus peuvent être individualisés en fonction du lieu de résidence, des paramètres sélectionnés ou des recherches antérieures.

Cette personnalisation explique pourquoi le détenteur d’un site va voir son site apparaître régulièrement en page 1. Cela ne signifie pas que le site en question est bien référencé pour les autres internautes.

Les annonces payantes de Google apparaissent également en fonction de l’analyse des recherches des internautes. Néanmoins, le fait d’opter pour le référencement payant n’améliore pas le référencement naturel.

En d’autres termes, la stratégie SEA ne donne pas de meilleurs résultats SEO.

Google attache une grande importance à la qualité des recherches des internautes.

Cela suppose de lutter contre l’ensemble des mauvaises pratiques de certains sites internet.

En effet, certaines entreprises ont eu la tentation de manipuler les robots d’indexation pour gagner artificiellement des places dans les résultats.

Avec ses opérations de crawling, Google lutte ainsi contre certaines pratiques précises :

Afin d’améliorer votre position sur les moteurs de recherche, comme Google, nous vous conseillons de suivre les étapes suivantes :

La compréhension des algorithmes de Google et du crawling nécessite expérience et expertise.

N’hésitez pas à demander les services d’un prestataire qualifié pour augmenter votre référencement sur le web sur Codeur.com.

Article rédigé par Amaury.

Abonnez-vous pour recevoir notre sélection des meilleurs articles directement dans votre boîte mail.

Nous ne partagerons pas votre adresse e-mail.