Crawlabilité de sites web : les erreurs les plus fréquentes

De nombreux sites web e-commerce ont vu le jour sur Internet ces dernières années. En cause, la démocratisation du digital, et...

De nombreux sites web e-commerce ont vu le jour sur Internet ces dernières années. En cause, la démocratisation du digital, et...

La position dans les pages de résultats Google est un facteur clé pour la performance d’un lien. Backlinko a analysé 5 millions de...

On en parle partout, tout le temps. Mais au fait, l’intelligence artificielle, c’est quoi ? The post IA : « il n’y a pas...

Profitez de la fin du mois d’août pour découvrir les logiciels Adobe ou perfectionner votre maîtrise de Photoshop, InDesign,...

Twitter est un réseau social atypique dit de microblogging. En d’autres termes, c’est un dérivé du blog mais en version...

Le secret pour que vos Facebook Ads percutent l’esprit de votre cible afin de doper vos conversions ? Maîtriser les punchlines à...

Le flat design et la 3D ont un enfant caché, c’est le design isométrique. Cette technique un peu particulière de graphisme permet de...

Vous cherchez à créer des palettes de couleurs ou à trouver des concordances de couleurs ? Voici Muzli Colors, l’outil parfait...

Instagram développe une toute nouvelle application de messagerie pour permettre aux amis proches d’échanger. Elle doit permettre aux amis...

Une nouvelle étude souligne le fait que les blogs ne sont souvent pas les meilleurs choix pour vous positionner sur Google, surtout si vous publiez du...

De nombreux sites web e-commerce ont vu le jour sur Internet ces dernières années. En cause, la démocratisation du digital, et l’ouverture à un...

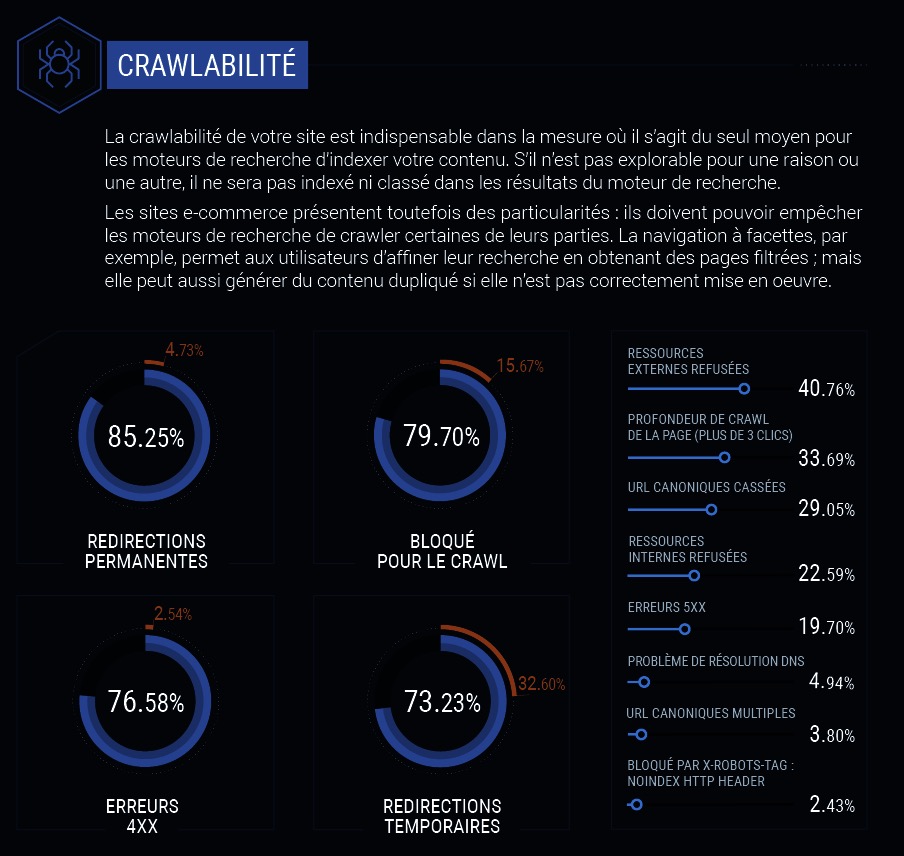

De nombreux sites web e-commerce ont vu le jour sur Internet ces dernières années. En cause, la démocratisation du digital, et l’ouverture à un comportement d’entrepreneur qui fait de plus en plus rêver.

Ce développement important, sous-entend une concurrence de plus en plus importante sur tous les secteurs commerciaux. Cette concurrence rend la visibilité toujours plus compliqué à obtenir, et confère au référencement naturel la grande mission de révéler les boutiques jugées les plus « pertinentes ».

C’est pourquoi nous avons décidé de faire le point sur les erreurs fréquentes autour de la crawlabilité. Cette notion aborde à la fois la façon dont Google (et les autres moteurs de recherche) va indexer votre contenu pour le rendre disponible aux internautes, mais aussi la manière dont ce contenu est accessible sur votre site web pour l’internaute.

Cet article est basé sur une étude réalisée par SEMrush.

Celles-ci pourraient être mieux gérées en définissant un plan de redirection clair, comme vous pouvez le faire pour l’arborescence de votre site.

À l’heure actuelle, pour vous rendre compte des problèmes de redirections, rendez-vous sur votre Search Console, et observez les problèmes de couverture rencontrés. Vous pourrez alors redéfinir vos redirections.

Nous vous conseillons également d’effectuer un travail « à la main », surtout si vous venez de changer de site web.

Parcourez votre ancien site page par page, et assurez-vous que l’ensemble des pages sont bien redirigées. Ceci vous permettra de conserver le jus et le trafic de ces pages, et de ne pas être considéré comme duplicate vis à vis d’une nouvelle page de votre nouveau site.

De nombreuses erreurs peuvent arriver sur un site web, surtout si celui-ci contient une quantité importante de pages. Ces erreurs peuvent venir :

Cette gestion de l’indexation est absolument essentielle sur un site e-commerce. Autrement dit, vous devez vous assurer de bien désindexer les bonnes pages, pour éviter d’avoir du duplicate content, et de perdre la puissance de vos pages.

Ce type d’erreur peut être évité en vous appuyant sur une arborescence complète de votre site web, construite de façon hiérarchique, et mise à jour lors de l’ajout ou du retrait d’une page. Ainsi, vous gardez en tête toute la structure du site web, ainsi que la possibilité d’intervenir sur un point précis sans risquer de déséquilibrer l’ensemble.

Également, comme pour le problème de redirections, pensez à consulter régulièrement votre Search Console. La couverture vous indiquera les erreurs d’indexation, les ressources bloquées, et tous les petits soucis techniques que votre site peut rencontrer.

Lorsque l’on parle de crawlabilité, on a souvent tendance à penser pour Google et sa capacité à indexer notre contenu. Mais n’oublions pas l’internaute et la performance que peut apporter un crawl on-site bien construit.

Vous l’aurez compris, la question du crawl sur le site, visant à accéder à un contenu désiré, est très importante. On considère généralement qu’il ne faut pas plus de 3 clics pour accéder au contenu souhaité. Votre site web respecte-t-il cette règle ?

Car si tel n’est pas le cas, la performance de votre site pourrait-être moindre avec des internautes impatients voire perdus sur le site.

Abonnez-vous pour recevoir notre sélection des meilleurs articles directement dans votre boîte mail.

Nous ne partagerons pas votre adresse e-mail.